自動運転車による事故発生時などの責任の在り方や社会的ルール整備に向けた議論が本格化し始めたようだ。デジタル庁はこのほど、「モビリティ・ロードマップ2024(仮称)」策定を進めるモビリティワーキンググループの下に、自動運転車の社会的ルールの在り方を検討するサブワーキンググループ(SWG)を設置し、有識者らの意見聴取を開始した。

人間の運転者が不在となる自動運転は従来の法規制で捉えきることができず、万が一の際に誰がどのように責任を取るべきかを明確化する必要がある。刑事責任の「免責規定」などが焦点になりそうだ。

2023年12月に初開催されたSWGでは、大学法学系の教授や弁護士ら6人の意見が記された資料がそれぞれ提出・公開されている。各有識者の見解を参照し、論点整理の方向性に迫る。

記事の目次

■京都大学大学院法学研究科教授 稲谷龍彦氏

AIシステムの安全性を監督する官庁創設を

自動運転車の安全性に関す行政規制については、規制側と被規制側との情報ギャップや規制の陳腐化の問題に鑑みて、政府から垂直的に規制をかける従来型の方法論に固執せず、性能規定などを利用した認証制度などを利用することで、民間サイドの創意工夫やイノベーションを生かしながら変化するリスクに対応できる方法論(アジャイル・ガバナンス)の活用を指摘している。

その際、被規制側によるモラルハザードを防ぎ、被規制側から規制のアップデートに必要な情報を提供するインセンティブを与えることで、法システム全体として持続的に安全性を向上させることができるよう、民事・刑事責任制度や制裁制度と併せ法制度の改革を進めるべきとしている。

民事責任については、自賠責法や製造物責任法、AI(人工知能)システム全般に関する一般的な民事責任法の望ましい在り方について、厳格補償責任などの採用も視野に入れ検討を進めるべきとのスタンスだ。

その上で、開発者が萎縮することのないよう免責条件についても適切に配慮するとともに、補償を受けることができない被害者が生じないよう保険制度や公的補償制度の整備についても議論を進めるべきとしている。

また、AIシステムの安全性を監督する官庁の創設にも言及している。関係省庁が多数にのぼる弊害を解消するため、一元的に取扱う官庁を創設し、制度整備についても当該官庁が中心となって実施すべき。適切な形でリボルビングドアを設け、民間の知識・経験を活用しながら実効的な安全性管理や事故調査制度を整備すべきとしている。

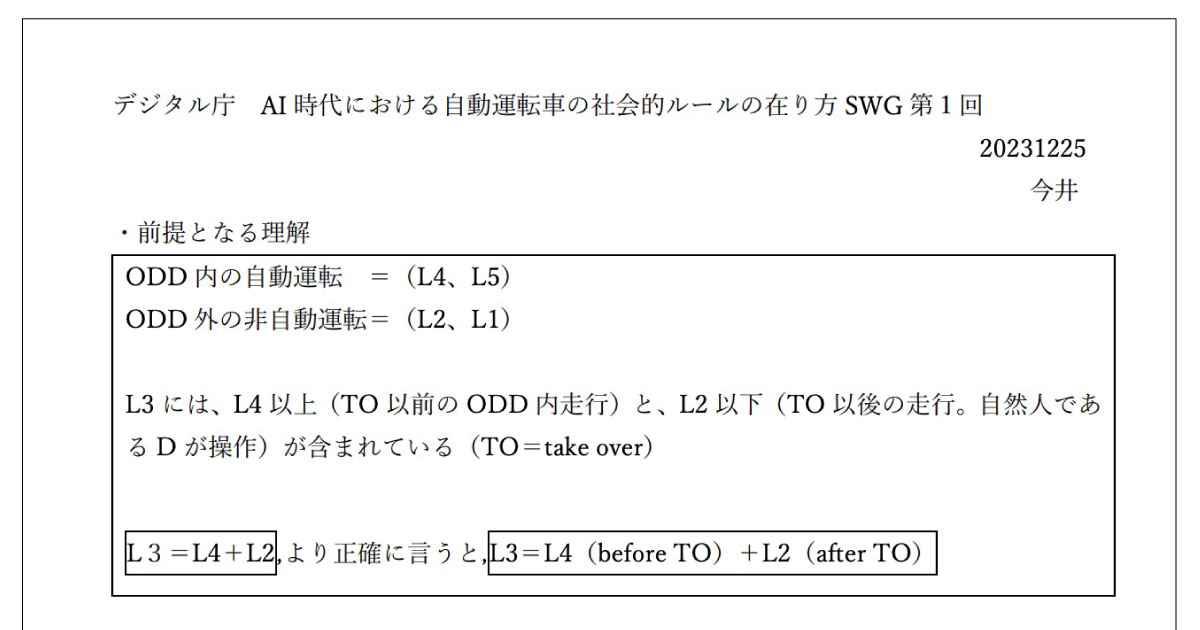

■法政大学大学院法務研究科教授 今井猛嘉氏

短期的には技術ガイドラインの充実が適当

短期的論点として、倫理ガイドラインではなく技術ガイドラインの精査を挙げている。ガイドラインの目的は「自動運転に無関係の人の生命を犠牲にして、自動運転関係者の生命を保護することは可及的に回避すべき」ということに要約でき、この目的に資するには倫理ガイドラインは不適当であり、技術ガイドラインを充実させることが適当という。

ODD(運行設計領域)内の事故発生確率など、統計データの分析も活用して想定される緊急事態に対する対処法を客観的に基礎付け、その実践を図ることが望まれる。

刑事法的には、ガイドラインは自動運行装置の設計者、自動運転車の製造または販売者、特定自動運行実施者などに対し、どこまでの行為が刑罰法規に触れないという意味で許されるかを示す目安でなければならない。ただし、ドイツ法由来の「許された危険論」は結論の先取りで不適当としている。

一方、長期的には、自動運転のAIがセルフラーニングによって当初のAIに想定されていたものとはまったく異なる情報処理結果を算出する可能性が高まっていく。

その可能性が実害を引き起こし得るものであったとしても、当該結果が発生する蓋然性をAI設計者が認識可能と言えなかった場合、その過失を肯定することは困難となる。

自動運転車との関係で倫理的に望ましい行動を求めるならば、その前提としてAIの法人格性や犯罪主体性の研究が深められる必要があるが、この検討は国際的にも始まったばかりであり、今後の研究の進展を待つ必要があるとしている。

■渥美坂井法律事務所・外国法共同事業プロトタイプ政策研究所所長・シニアパートナー弁護士 落合孝文氏

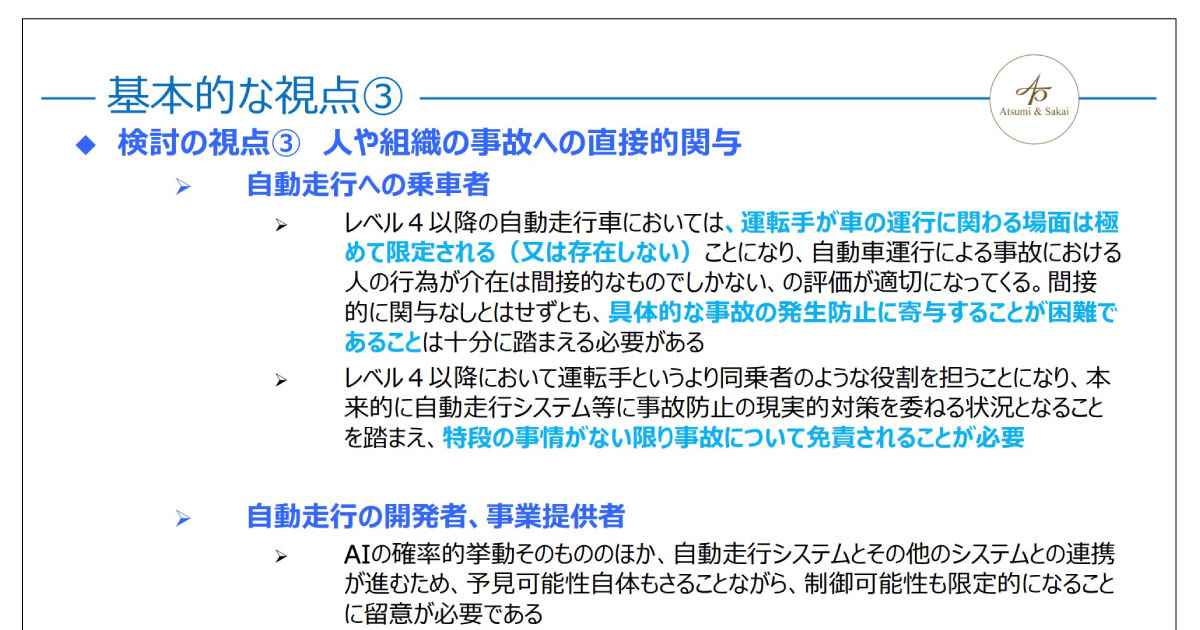

個人の過失に対する責任は原則として免責されるべき

自動運転車の乗車者や開発・関係サービス提供者にとって、極端に高度な注意義務や事故回避対応を求めることは、開発・事業化、利用にとって大きな阻害要素となる。

レベル4以降の自動運転は、事故における人の介在は間接的なものでしかない。関与なしとはいかなくとも、事故発生防止に寄与することが困難であることは十分に踏まえる必要がある。

また、開発者や事業提供者は、自動運転システムとその他システムとの連携が進むため予見可能性や制御可能性が限定的になることに留意しなければならない。

民事における被害者への補償が完備されることは必要だが、加害者としての開発者、事業提供者への応報や、これらの者や第三者への抑止効果としての刑事罰などの執行は、自動運転に関する事業の健全な改善に向けたインセンティブにならない可能性がある。

こうした観点から、行政規制においては、義務体系の設計が民事・刑事の責任に影響を及ぼすことを踏まえた議論が必要で、民事、刑事における各関係者の責任が合理的になるよう、誰がどのような規制を負うことで事故や被害の拡大防止、自動運転事業の継続的改善を図るゴールを達成できるか、規制を構築し直すことが重要としている。

刑事責任については、個人の過失に対する責任は原則として免責されるべきだが、一部の行政規制違反や故意による行為の処罰については維持が必要で、原因究明への協力義務や事故拡大防止の協力義務などについては強化が必要とした。

■森・濱田松本法律事務所 パートナー弁護士 佐藤典仁氏

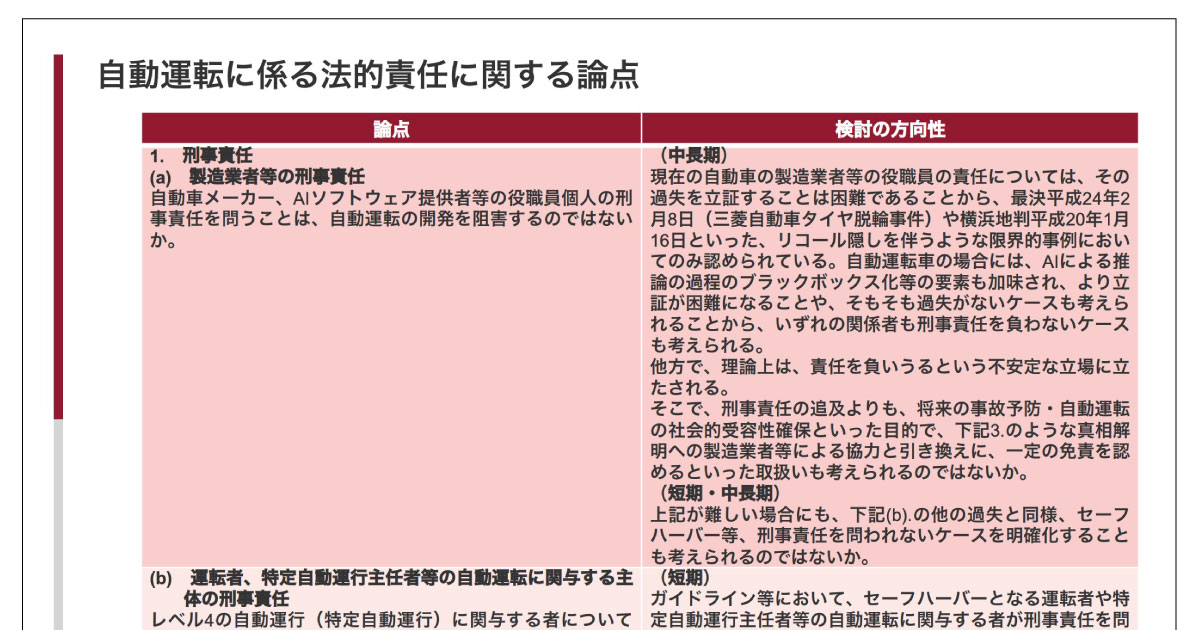

セーフハーバーなど刑事責任を問われないケースを明確化すべき

刑事責任において、自動車メーカーやAIソフトウェア提供者らの役職員個人の刑事責任を問うことは、自動運転の開発を阻害する恐れがある。

刑事責任の追及よりも、将来の事故予防や自動運転の社会的受容性確保といった観点から、真相解明に向けた製造業者らによる協力と引き換えに一定の免責を認めるといった取扱いも考えられる。短期・中長期には、他の過失と同様セーフハーバーなど刑事責任を問われないケースを明確化することも考えられる。

民事責任関連では、手動運転よりも安全であるものの、人間の運転者が起こさないような事故を1件起こしてしまったような場合、その欠陥の有無をどのように考えるべきか、事後的に「注意深く有能な運転者と同等以上のレベル」などの保安基準を満たさないと判断し、欠陥ありとなるのか……と課題を指摘している。

事前に「通常有すべき安全性」の判断が難しく、開発者サイドからすると安心して自動運転車を実用化できない恐れがある。欠陥ありとされる範囲について一定の明確化が必要で、これに向け解釈の方向性をガイドラインなどで示すことも考えられる。

また、ソフトウェアアップデートを前提に販売するケースやAIによる機械学習が想定されるにもかかわらず、欠陥の判断基準時を自動車の引渡し時として販売後の事情を考慮しないことは被害者保護に欠ける。

アップデート提供時を欠陥の判断基準時とし、機械学習に対応できる法的整理を考える必要があるとしている。

■髙橋正人法律事務所 弁護士 髙橋正人氏

民事免責や刑事免責を拙速に創設すべきではない

髙橋氏は犯罪被害者支援弁護士フォーラム事務局長を務めており、その立場が強く反映された意見を提出したようだ。

科学を利用する主体は国民であり、大多数の国民のコンセンサスが得られなければ科学への信頼は失われるとし、自動運転においては、ユーザーや自動車メーカー、自動車保険会社、交通犯罪被害者のコンセンサスを念頭に置くべきとした。

その上で交通犯罪被害者からの信頼を重要視し、被害の回復を加害者が、加害者ができない場合は国家が代行し担保する必要があるとしている。加害者への刑罰は、被害回復に向けた国家による代行という見解だ。

その仕組みが保障され、加害者に適正な刑罰が課されるとの信頼があるからこそ司法や国家が信頼され、社会の秩序を保つことができるという。これらの理由により、民事免責や刑事免責については拙速に創設すべきではないとしている。

このほか、自動運転が交通に関する法令の解釈・裁判例のすべてに対応できているか?――といった疑問も投げかけている。現在の道路交通法や自動車運転死傷行為等処罰法の解釈適用は司法・裁判例によるが、こうしたものに適切に対応できるかを問うている。

■日本自動車工業会 安全技術・政策委員会 自動運転タスクフォース主査 波多野邦道氏

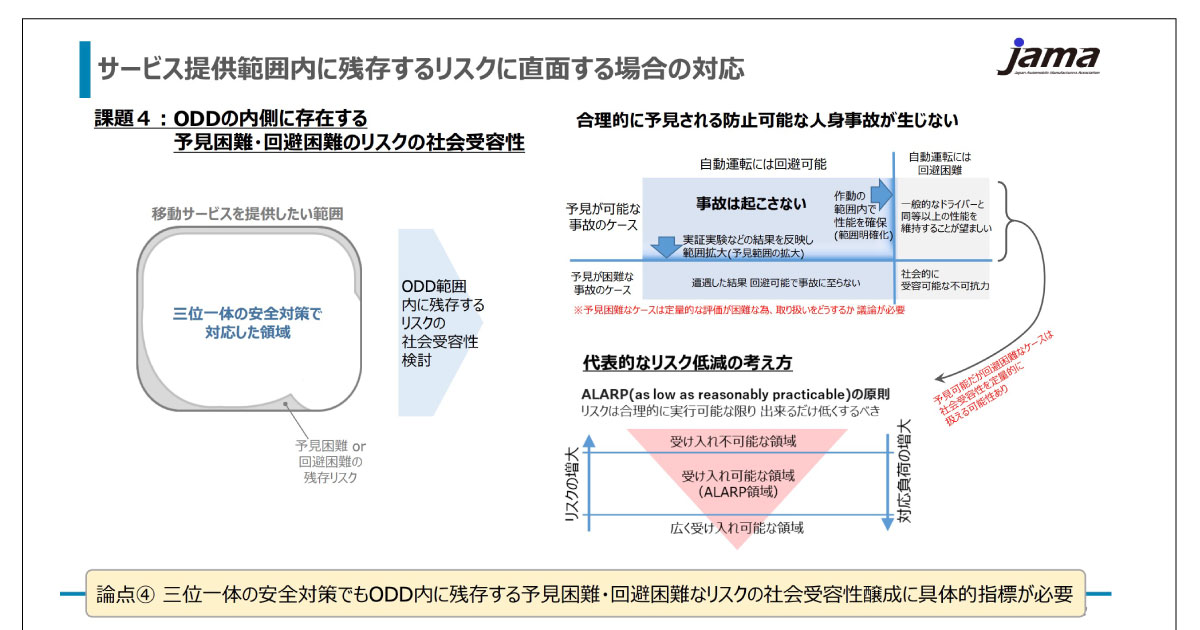

事故回避が困難なケースの社会受容基準や予見困難な事故ケースの取り扱いを協議

自動運転の社会実装にはクルマのみならず人、交通環境と連携した三位一体の取り組みが重要とし、それぞれ解決すべき課題を抽出した上でアクションプランを取りまとめる必要があるとした。

移動サービスを提供したい範囲が、自動運転システムが安全を担保できる範囲を超える場合、それを満たすためにはシステムの性能限界の拡大やインフラ整備・協調システムなどによる支援、交通参加者をはじめとした人のルール遵守などが求められる。

このため、システム性能限界見極めに資する検証範囲と判断基準に関する協議や性能限界を拡大する際の確認方法の具体化、ODD内に残存する予見困難・回避困難なリスクの社会受容性醸成に資する指標、サービス開始の判断や開始後に発生するインシデントに関する要因別の対応の在り方の整合などを図っていく必要があるとしている。

また、人間同様、自動運転車も事故を100%予見できるわけではなく、目前の飛び出しなど欠陥や過失がなくても事故が回避困難なケースは存在する。合理的に予見される事故ケースの有限化と回避性能の判断基準の明確化するとともに、回避困難なケースの社会受容基準や予見困難な事故ケースの取り扱いに関する協議をサブワーキンググループに求めている。

■【まとめ】開発者サイドへの免責条項が必要?

被害者救済や事故調査制度の必要性は当然として、有識者の多くは開発の停滞を招かないよう開発者や事業者サイドに過度な責任を押し付けるべきではないといったスタンスをとっているようだ。

自動運転システムの瑕疵や過失をどのように判断・線引きし、どこまで責任を求めどこから免責すべきか……といった点に焦点が当てられそうだが、AIの性能・判断指標などが時とともに変化することを前提とすれば、可変的な対策が求められるなど課題は山積している。

今後、他の有識者の意見も踏まえて論点整理が進められる見込みだ。最終的にどのような方向性が示されるか、しっかりと注目したい。

※自動運転ラボの資料解説記事は「タグ:資料解説|自動運転ラボ」でまとめて発信しています。

【参考】関連記事としては「自動運転バス導入「6,500万〜1億円」 デジタル庁、費用例を記載」も参照。