国立研究開発法人「産業技術総合研究所」(産総研)は2023年10月3日までに、「視覚情報から物体間に働く力を想起する能力」をAI(人工知能)が再現することに成功したと発表した。

この技術は、視覚情報のみから「崩しそう」「つぶしそう」と想像する能力をAIが獲得し、物体を「壊さないよう」人間らしい推論に基づく行動をAIが立案するというものだ。店舗や工場、物流倉庫におけるロボットの作業、カメラによる事故予測などの応用が期待されている。

■視覚情報から物体間に働く力を想起

人間は過去の経験に基づき、視覚から別の感覚を想起することで、柔軟で多様な作業を行うことができる。例えば、目で見た情報から、柔らかいものや崩れやすいものは丁寧に操作するよう意識する。

ロボットは、搭載される視覚センサーだけでこういった感覚を再現することは難しく、ロボットと物体の接触後に、力覚センサーや触覚センサーを使って判断するといった流れになっている。しかし物体に接触してからの判断では遅い場合もあり、対象物が崩れてしまうなど、細かく丁寧な作業においての課題があったという。

これを解決するため、産総研は視覚情報から物体間に働く力を想起するAI技術を開発した。なおこの研究開発は、科学技術振興機構(JST)のムーンショット型研究開発事業研究開発事業「2050年までに、AIとロボットの共進化により、自ら学習・行動し人と共生するロボットを実現」による支援を受けた研究開発プロジェクト「一人に一台一生寄り添うスマートロボット」の研究課題の1つとして行われている。

■AIは人間らしい推論に基づく行動が可能に

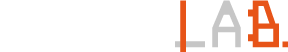

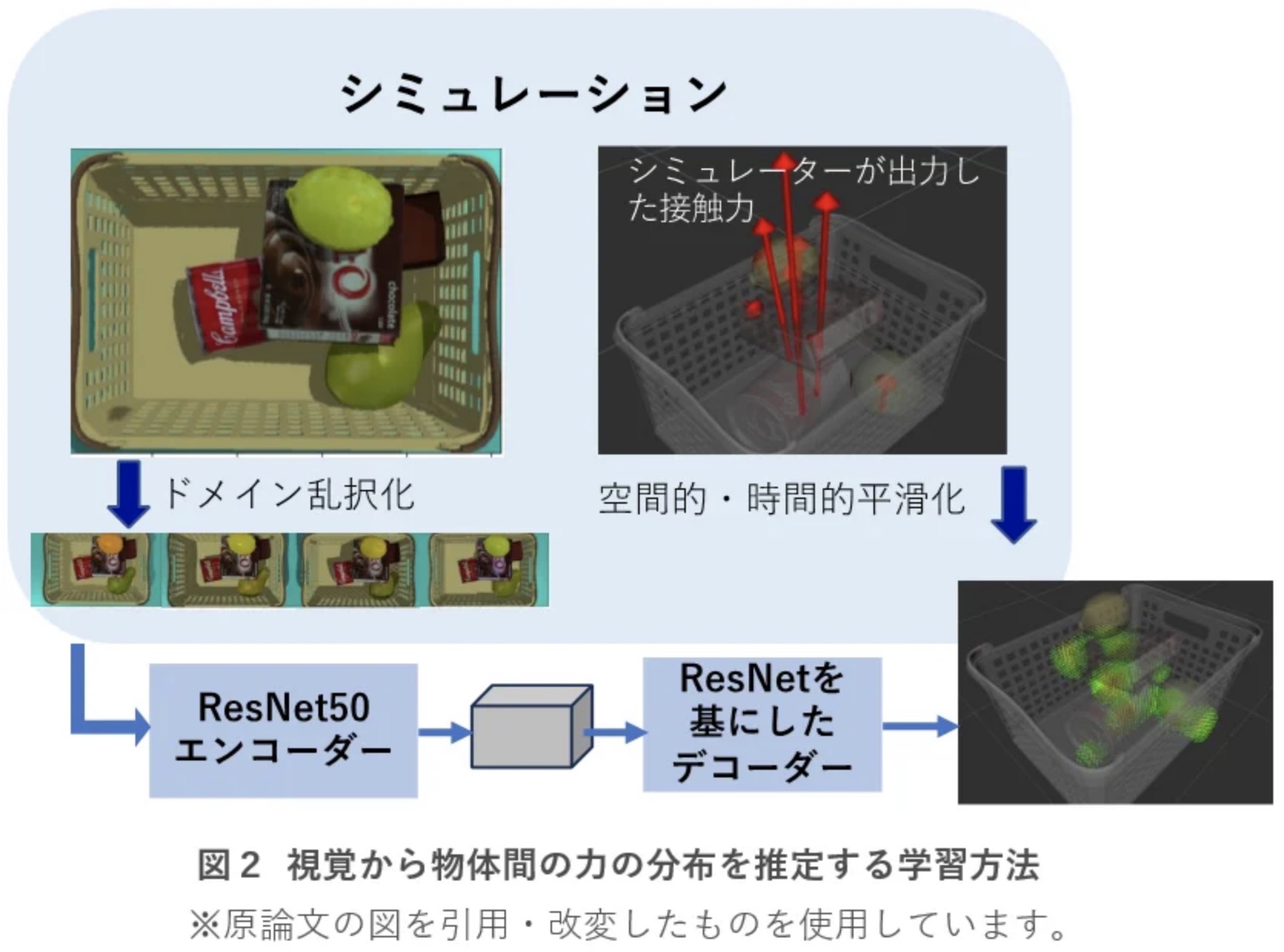

今回開発された技術は、物理シミュレーター上で物体間にかかる力を可視化した仮想的な経験データを構築し、この仮想的な経験から視覚と別の感覚(力)の関係をAIが学習することにより実現している。

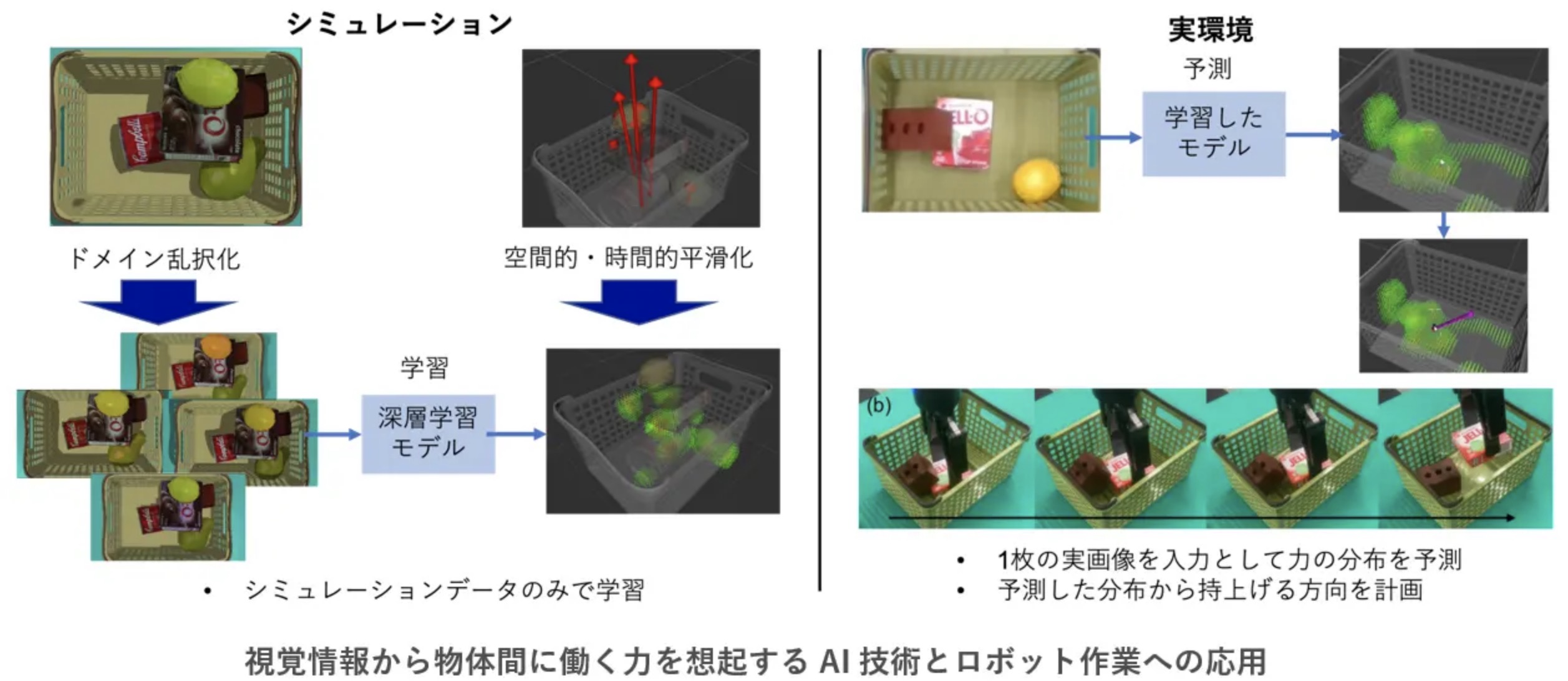

研究では、視覚センサーにより得られる画像に写る物体が周囲の物体と接触することで生じる力のおおまかな分布を想起し、リアルタイムに3次元で可視化することに成功した。今回開発したAI技術では、物体同士が接触することで生じる力を画像から推定し、力の大小を視覚的に表現することができるという。

さらに、力分布を理解したロボットが周辺の物体の損傷が小さくなるように指定された対象物を持ち上げるなど、人間らしい推論に基づく行動ができることを確認した。将来的には、器用に物体を操作するロボットへの応用が期待されている。

■自動運転システムにも活用が見込める技術

今回の視覚から別の感覚を想起する技術は、安価なセンサーにより人間らしい器用な行動計画を実現できるため、工場や物流倉庫におけるロボットによる物体操作のほか、家庭用スマートロボットへの展開が見込めるという。またシミュレーションによる経験データの作り方・与え方を工夫することで、自然環境において崩れやすそうな場所を見つけるという応用も想定されている。

今後の目標として、自動運転での事故予測などの危険予知や、衛星画像からの災害予知などへの適用が期待されている。

技術開発により、AIがより人間らしい感覚を身につけると、ロボットなどが活用できるフィールドは大幅に拡大できそうだ。この技術を応用し、自動運転システムでの運用にも期待がかかる。

【参考】関連記事としては「スマホのカメラで自動運転!産総研が「凄い技術」発表」も参照。